اسکریمینگ فراگ یک خزنده وب سایته که با استخراج و بررسی دادههای موجود در سایت، در بهینه سازی سئو سایت شما نقش داره. screaming frog که برای آنالیز سئو مورد استفاده قرار میگیره و یکی از ابزارهای سئو محسوب میشه؛ برای سیستم عاملهای ویندوز، مک و لینوکس اوبونتو طراحی شده. در ادامه این مقاله به بررسی بیشتر این نرم افزار میپردازیم و ویژگیهای برجسته اون رو براتون شرح میدیم.

اسکریمینگ فراگ چیست؟

این قورباغه جیغ جیغو در بین لینکها، تصاویر، کد css و… اینور و اونور میره و بهتون اطلاع میده که خزندههای گوگل در هنگام خزیدنشون توی سایت شما به چه چیزهایی برخورد میکنن. جمع آوری داده توسط این نرم افزار علاوه بر اینکه روی وقت و انرژی شما صرفه جویی میکنه، باعث میشه خیلی راحتتر به اطلاعاتی که برای بهینه سازی سایتتون نیاز دارید، دست پیدا کنید. در واقع نرم افزار اسکریمینگ فراگ میتونه به شما نشون بده که خزندههای گوگل از چه دیدی به وضعیت سایت شما نگاه میکنن و در آخر یک نتیجه گیری جامعی از سئو تکنیکال سایتتون ارائه میده که شما میتونید با این اطلاعات به رفع خطاها و بهبود رتبه کلی سایتتون بپردازید تا در رتبه بندی موتور جستجو گوگل که بر اساس الگوریتمهای گوگل انجام میگیره، بتونید رتبه خوبی کسب کنید. نسخه رایگان اسکریمینگ فراگ حدود 500 url رو براتون تحلیل میکنه و شما برای اینکه به صورت نامحدود به قابلیتهای این نرم افزار دسترسی داشته باشید، میتونید نسخه پولی اون رو تهیه کنید.

کاربردهای screaming frog چیست؟

در این قسمت از آموزش اسکریمینگ فراگ میخوایم براتون از کاربردها و ویژگی این نرم افزار قدرتمند بگیم.

قابلیت نمایش تمامی لینکهایی که در سایت قرار دارند، از جمله لینکهای داخلی و بک لینک

نمایش خطاهای سرور

اتصال به گوگل سرچ کنسول از طریق APL، گوگل آنالیتیکس و باقی ابزارهایی که قابلیت آمارگیری دارند

نشان دادن لینکهای خرابی که در سایت هستند

امکان آنالیز سئو سایتهای مختلف

بررسی عنوان و متا صفحات

شناسایی لینکهای تکراری در صفحه

قابلیت ایجاد نقشه سایت

نمایش مواردی مثل عنوان، متا، آدرس، کلمات کلیدی و…

یوزر فرندلی بودن

دارای رابط کاربری واضح

ایندکس کردن وب سایتهای قوی در جاوا اسکریپت

شناسایی تصاویر بدون alt text و آنالیز سئو تصاویر

یافتن محتواهای تکراری

تجزیه و تحلیل سرعت سایت

مزایای استفاده از screaming frog

در ادامه به بررسی مزایای این نرم افزار جیغ جیغو میپردازیم.

قابلیت برنامه ریزی

شما میتونید قابلیتی رو در این نرم افزار تنظیم کنید که بر اساس اون بررسی جزئیات مختلف سایتتون درزمانهای مشخصی صورت بگیره.

امکان اتصال و ادغام GSC & PSI با GA

امکان اتصال به Google Analytics، Search Console و PageSpeed Insights API از طریق این نرمافزار وجود داره.

امکان سرچ HTML

هر آنچه که نیاز دارید، میتونید در source code پیدا کنید. این کد میتونه Google Analytics code, specific text یا هر کد دیگهای باشه.

استخراج دادهها با XPath

جمعآوری هرگونه داده از HTML یک صفحه وب با استفاده از CSS Path، XPath یا regex امکانپذیر هست. این امکان شامل تگهای متا اجتماعی، عناوین اضافی، قیمتها، SKU و… هست.

معایب ابزار screaming frog

همونطور که قبلا هم گفتم ابزار Screaming Frog یکی از قدرتمندترین و محبوبترین ابزارهای SEO برای بررسی وبسایتهاست. با این ابزار، میتونید به راحتی و با سرعت بالا، اطلاعاتی مثل ساختار وبسایت، محتوای صفحات، مشکلات فنی، لینکهای داخلی و خارجی و بسیاری از موارد دیگه رو بررسی کنید؛ ولی خب همونطور این ابزار هم مثل ابزارهای دیگه معایب خودش رو داره:

نیازه به آموزش و تجربه داره: استفاده از این ابزار برای کاربرانی که تازه وارد حوزه SEO شدن سخت میتونه باشه. برای استفاده بهینه از اسکریمینگ فراگ، به تجربه کافی در زمینه SEO و تکنیکهای مربوط بهش نیازه.

محدودیت داره: نسخه رایگان Screaming Frog در تعداد صفحاتی که میتونید برای بررسی وبسایت خودتون استفاده کنید محدودیت داره. برای دسترسی به تمام قابلیتهای این ابزار، باید نسخه پولی این ابزار رو خریداری کنید.

تحلیل خودکار داره: بعضی از اطلاعاتی که Screaming Frog به شما میده، نیاز به تحلیل دقیق و تفسیر مناسب داره؛ به عنوان مثال، این ابزار به شما اطلاعاتی درباره لینکهای داخلی و خارجی وبسایت میده؛ اما برای استفاده بهینه از این اطلاعات، به تحلیل دقیق ترافیک و کیفیت لینکها نیاز پیدا میکنید.

فقط یک ابزاره: Screaming Frog فقط یکی از ابزارهای SEO محسوب میشه و برای انجام تحلیل بهتر وبسایت و به دست آوردن نتایج بهتر، به استفاده از ابزارهای دیگهای نیاز پیدا میکنید.

آموزش ابزار اسکریمینگ فراگ

همه سئو کارها باید نحوه کار کردن با بخشهای مختلف این نرم افزار رو یاد بگیرن؛ با ما همراه باشید تا از بفهمیم حرف حساب این قورباغه جیغ جیغو چیه؟

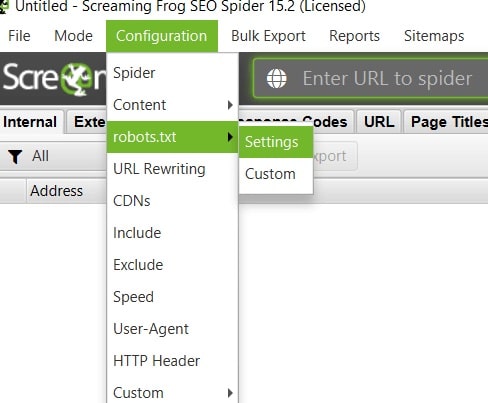

تنظیمات فایل robots.txt

بعد از اینکه به برنامه وارد شدید، لازم هست که قابلیت دسترسی به تمام صفحات سایت رو فعال کنید. برای این منظور از منوی Configuration و انتخاب زیر منوی robots.txt گزینهی Setting رو انتخاب کنید

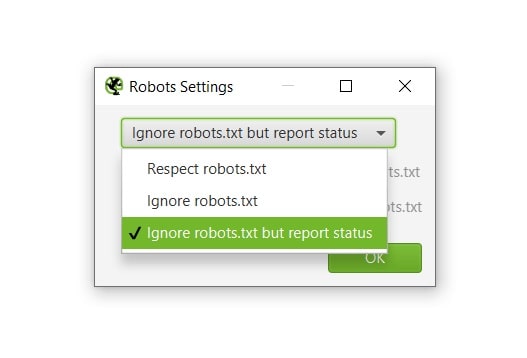

در پنجرهی جدید گزینهی ignore robot.txt but report status رو انتخاب و روی ok کلیک کنید، تا نرم افزار بسته شدن و اجازه ندادن دسترسی به اطلاعات فایل robots.txt سایت رو گزارش کنه.

نحوه آنالیز وبسایت

بعد از انجام این تغییرات در قسمت نوار آدرس (Address Bar)، آدرس سایت خودتون رو وارد کنید و روی دکمهی Start کلیک کنید تا نرم افزار آنالیز وب سایت رو شروع کنه. دقت کنید که نیازی به وارد کردن پیشوند نام وب سایت نیست و نرم افزار به صورت خودکار اون رو شناسایی میکنه. همچنین مدت زمان آنالیز وب سایت با توجه به صفحات وب سایت متغیر هست؛ در واقع هرچه تعداد صفحات سایت بیشتر باشه، مدت زمانی که برنامه برای آنالیز سایت نیاز داره هم بیشتر هست.

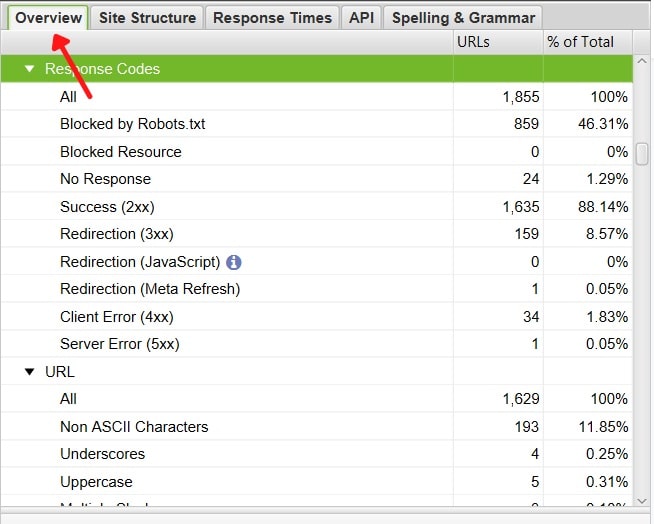

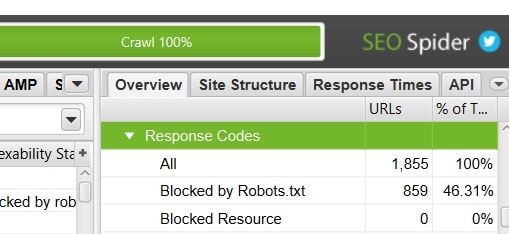

بخش Overview

منوی Overview که در سمت راست نرم افزار قرار داره، اطلاعاتی مثل تعداد کل URLهای وبسایت، تعداد URLهای داخلی و خارجی وبسایت و… رو نمایش میده. در قسمت Site Structure ساختار سایت، و در بخش Response Times زمان پاسخگویی و در آخرین قسمت APIهای مختلف برای ارزیابی وبسایت وجود دارند و در ستون پایینی هم یک نمودار وجود داره که بخشهای مختلف رو نمایش میده.

بخش Properties

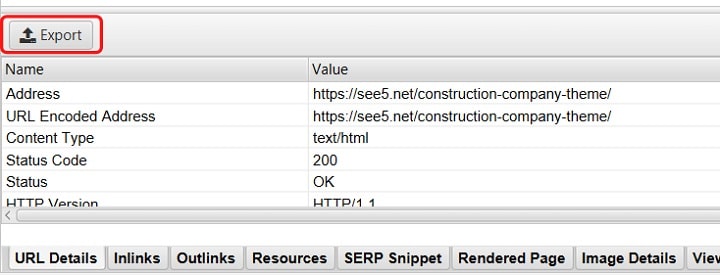

در پنجرهای که در تصویر پایین از محیط نرم افزار مشاهده میشه، میتونیم توضیحات تکمیلی مربوط به آیتمهای مورد نظر در کادر بالا رو که با کلیک روی اون، به حالت انتخاب دراومده مشاهده کنیم.

فیلتر Category

موارد مهمی مثل امکان نمایش دسته بندی و گروه بندیهای مختلف سایت در این قسمت قرار داره. همچنین میتونیم با آنالیز سایت رقبا و مشاهدهی دسته بندی مختلف سایتهاشون، اطلاعات بسیار کامل و جامعی رو به دست بیاریم که بررسی این اطلاعات میتونه در ارتقا سایت ما موثر عمل کنه.

فیلتر Internal

فیلتر Internal شامل لینکهای داخلی استفاده شده در تمام صفحات وب سایت هست.

فیلتر External

فیلتر External که توی عکس بالا هم هست برامون مشخص میکنه که از سایت مبدا به چه سایتهای دیگهای لینک داده شده.

فیلتر Protocol

این فیلتر صفحاتی که ریدایرکت شدن رو نمایش میده و شما میتونید صفحاتی که هنوز ریدایرکت روی اونها اعمال نشده رو مشاهده کنید.

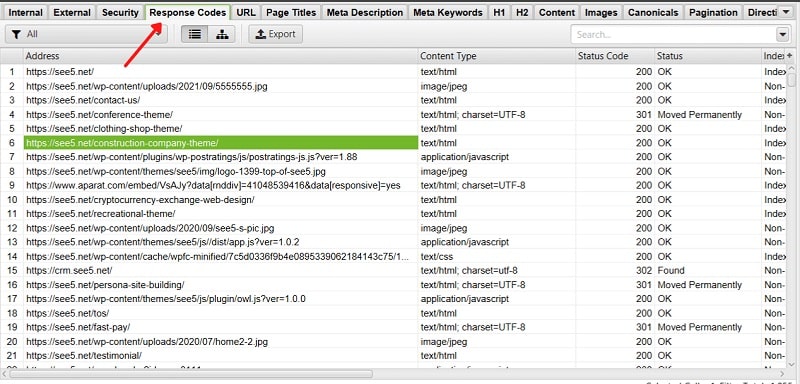

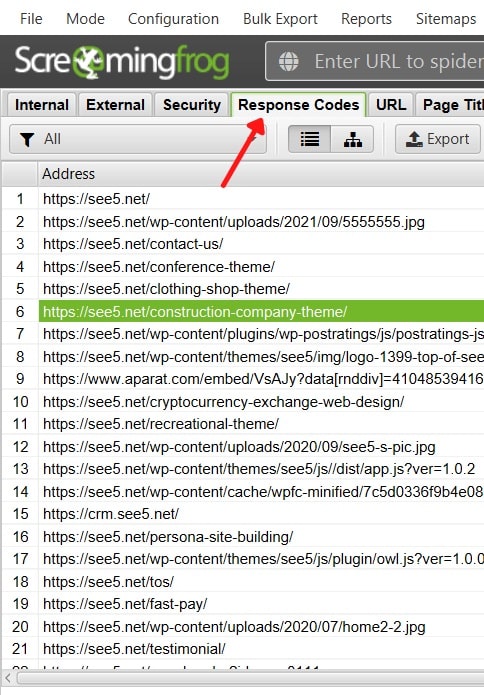

فیلتر Response Codes

یکی از فیلترهای کاربردی و مهم این نرم افزار، فیلتر Response Codes هست که میتونیم مباحث تکنیکال سئوی وب سایت شما رو تا حد زیادی پوشش بده. نکتهی مهمی که وجود داره اینه که این بخش در سایتها به راحتی قابل نمایش نیست و نمیتونیم به سادگی بهش دسترسی داشته باشیم.

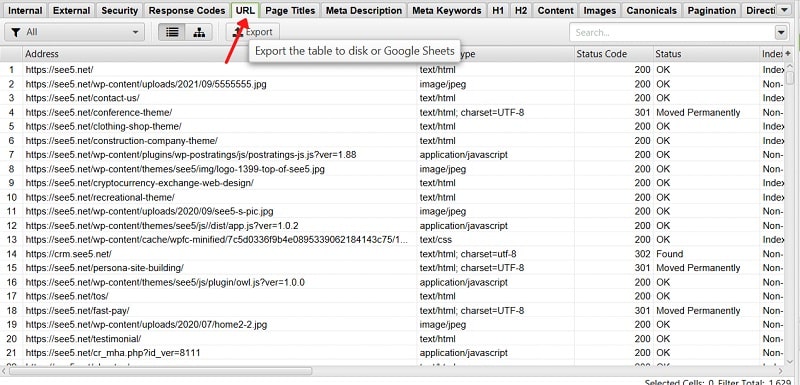

آنالیز تمام urlهای سایت

مواردی در آدرسهای سایت هستن که میتونن مشکلات نمایه سازی ایجاد کنن؛ پس باید شناسایی و رفع بشن؛ مشکلاتی نظیر urlهای طولانی، حروف بزرگ، تکراری، underscores، کدهای اسکی (ASCII) جزو مواردی هستند که باید بررسی و رفع بشن.

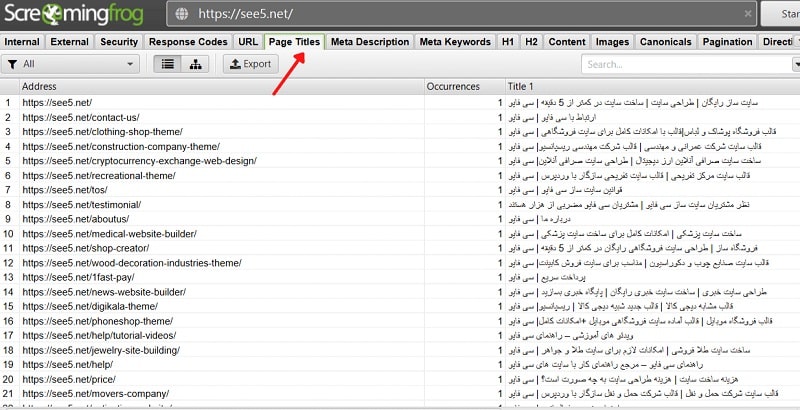

عنوان صفحه

هر صفحه باید عنوان جدایی داشته باشه و حاوی کلمات کلیدی اون صفحه هم باشه. اگر شما برای تمام صفحات سایتتون از یک عنوان استفاده کردید باید سریعا اونها رو درست کنید؛ همچنین استفاده از عنوانهای طولانی خوب نیست؛ چرا که اولین چیزی که کاربر در صفحه جستجو مشاهده میکنه عنوان صفحه شماست و اگر این عنوان طولانی باشه، گوگل قسمتای اضافی عنوان رو حذف میکنه و به کاربر نمایش نمیده.

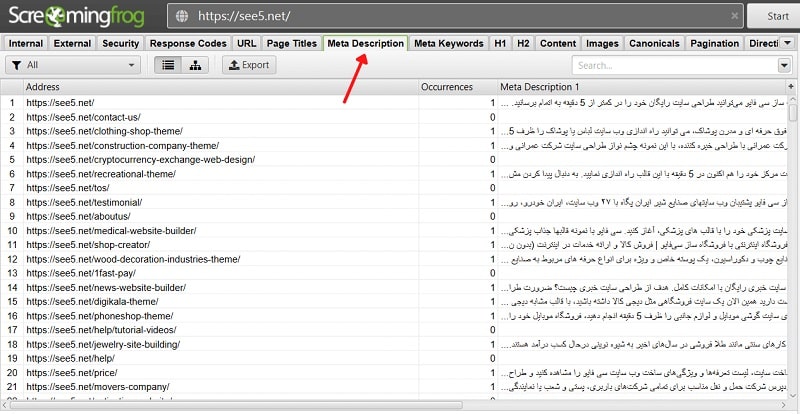

توضیحات متا

همونطور که میدونید توضیحات متا باید 750 پیکسل باشه و ابزار اسکریمینگ فراگ به شما در قرار دادن یک متا خوب و کارآمد کمک میکنه. اگر در قسمت META DESCRIPTION در ابزار قورباغه جیغ جیغو چیزی رو مشاهده نکردید، به این معنی هست که باید متا پیشنهادی خودتون رو برای اون صفحه بنویسید؛ همچنین ویژگی جدید این نرم افزار امکان تجزیه و تحلیل یک اسنیپت فیچر رو برای شما فراهم میکنه و شما میتونید عنوان و متای پیشنهادی خودتون رو در اون قرار داده و بعد مشاهده کنید که از دید مخاطب چطور نمایش داده میشه.

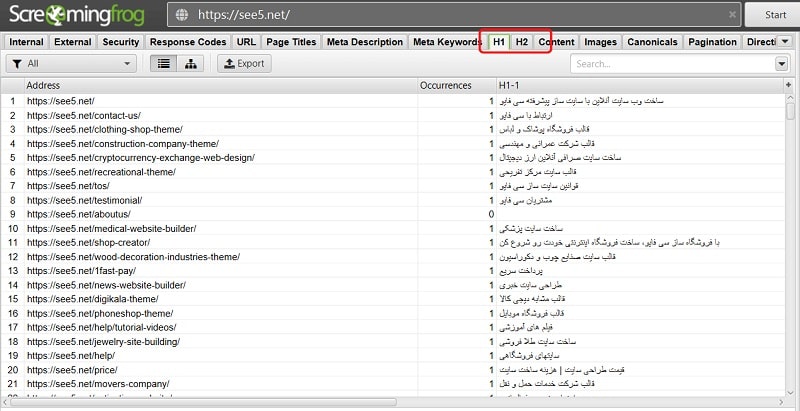

فیلتر H1,H2, Images

این 3 فاکتور که از مهمترین موارد برای سئو سایت به شمار میان رو میشه در این بخش بررسی کرد. تو این بخش نشون داده میشه که آیا این موارد در صفحات سایت و مطابق با استانداردها قرار داده شدن یا نه؟

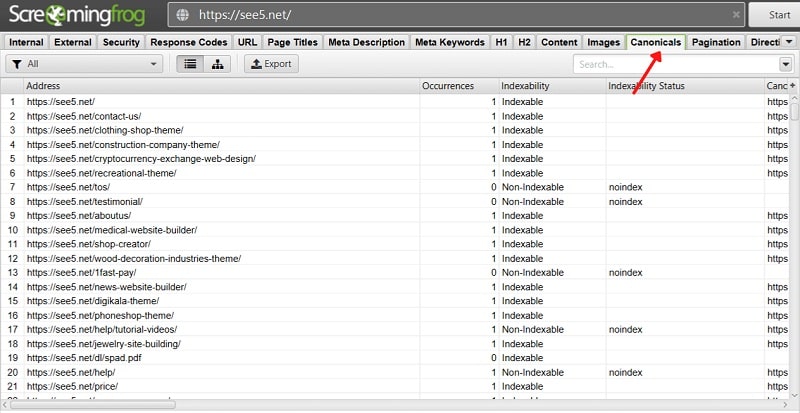

فیلتر Canonicals

فیلتر Canonicals مواردی که در سایت از یک بخش دیگه کپی شدن رو مشخص میکنه.

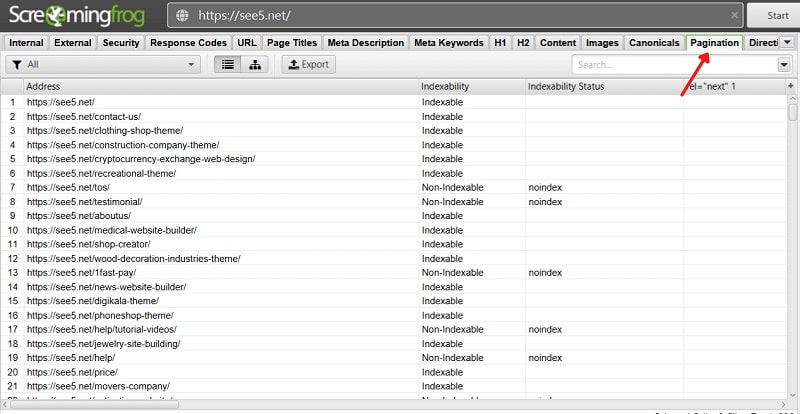

فیلتر Pagination

فیلتر Pagination صفحاتی از سایت که توی اونها از علامتهای صفحهی قبل و صفحهی بعد استفاده شده رو نمایش میده.

فیلتر Directives

این بخش نشون میده که چه فعالیتهایی در سایت در حال شکلگیری هستن.

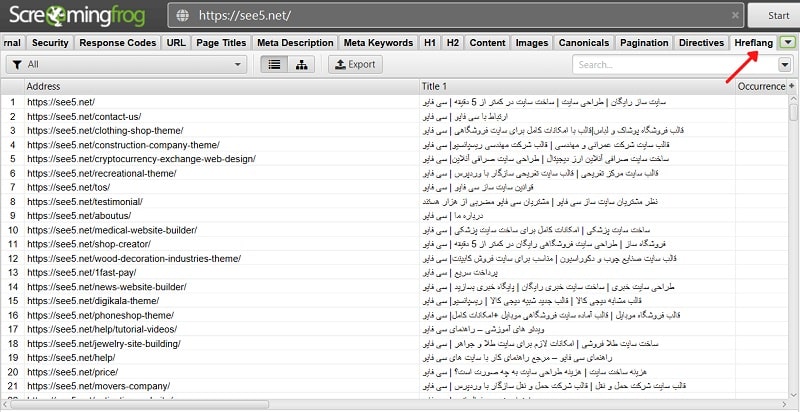

فیلتر Hreflang

فیلتر Hreflang فعالیت کاربر رو با توجه به آدرس IP و موقعیت مکانی که از طریق آن به سایت وارد شدن رو آنالیز میکنه. این فیلتر برای سایتهای چند زبانه و چند منظوره با پسوند مختلف مناسب هست؛ چون که از طریق آدرس IP، زبان کاربر رو شناسایی میکنه و اون رو به دامنه و پسوند متناسب با منطقهی جغرافیایی مربوط به خودش هدایت میکنه.

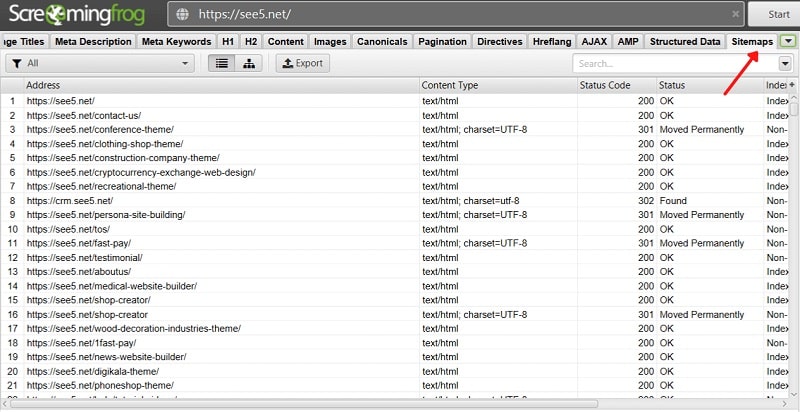

فیلتر Sitemap

از Screaming Frog میتونید برای ایجاد نقشه سایت استفاده کنید. موتورهای جست و جو، این نوع نقشه سایت رو برای بررسی مجدد مرتبط بودن محتوا، به کار میگیرن. این نقشه راهی هست که موتورهای جستجوگر رو هدایت میکنه که داخل سایت شما رو بخزند. این گزینه رو میتونید در بخش بالایی ابزار، زیر Sitemaps > Create XML Sitemap پیدا کنید. بعد از ایجاد فایل، میتونید به صورت دستی اولویتبندی و صفحات رو مرتب کنید.

آموزش کار با screaming frog

مرحله اول، با دانلود این برنامه به صورت کرک شده از سایت معتبر شروع میشه. شما میتونید این نرم افزار رو راهاندازی کنید و گزارشات مختلف از دادهها، لینکها و… رو دریافت کنید.

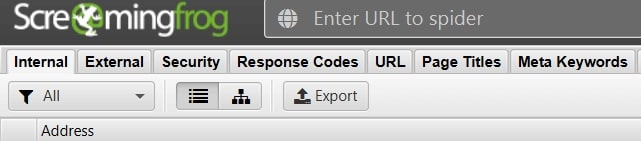

وارد کردن آدرس صفحه

با وارد کردن URL سایت خودتون در قسمت مورد نظر میتونید با کلیک روی دکمه Start فعالیت خودتون رو آغاز کنید؛ در ادامه این روند باید در انتظار Crawl شدن آدرس باشید تا دادههای موجود رو دریافت کنید. بعد از وارد کردن اون میتونید تمامی اطلاعات، مثل لینکهای داخلی، خارجی، توضیحات متا، سرعت سایت و… رو مشاهده کنید. اطلاعات مهم دیگه، مثل ایندکس شدن صفحه هم در این نرم افزار میتونه اطلاعات خوبی رو در اختیارتون بزاره؛ همچنین امکان مشاهده خطاهای سایت هم وجود داره.

مشخص کردن Mode

با مشخص کردن mode میتونید به صورت دلخواه منوی خودتون رو به نمایش بذارید و هرجوری که میخواید لینکها و آدرسهای مورد نظر رو مشاهده و بررسی کنید.

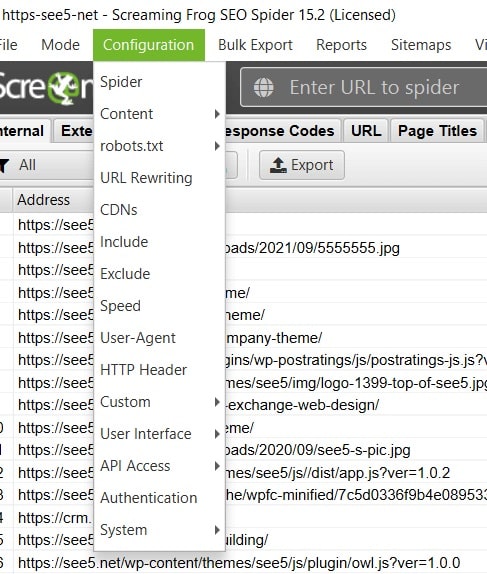

منوی configuration

شما میتونید در منوی Configuration با تنظیم Exclude پیکربندی برنامه رو به حالت پیش فرض گوگل قرار بدید تا اینجوری برنامه مثل خزندههای گوگل برای شما عمل کنه. یکی از متداول ترین روشهایی که تعداد زیادی از افراد از اون استفاده میکنن، استفاده از گزینه Exclude هست. اگر از کدهایی مثل JS استفاده میکنید با مراجعه به این قسمت Configuration > Spider > Rendering میتونید نوع خزیدن اونها رو مشاهده کنید.

جزئیات Response Codes

این قسمت شامل بخشهای مختلفی هست. با مراجعه به این بخش میتونید error مورد نظر رو بررسی کنید.

شناسایی خطاها و مشکلات

کافیه به قسمت Overview مراجعه کنید و در هر زبانه مشکلات موجود رو مورد بازبینی قرار بدید. از اونجایی که این ابزار امکان برطرف کردن خودکار مشکلات سایت شما رو نداره؛ شما باید به صورت دستی هر یک از دادهها رو شناسایی کنید و بعد، در سایت اقدام به برطرف سازی مشکلات کنید.

دریافت دادهها به صورت فایل Excel

با وارد کردن هر آدرسی میشه تمامی اطلاعات مورد نظر از جمله لینکهای داخلی، لینکهای خارجی و… رو دریافت کرده و مورد بررسی قرار داد.

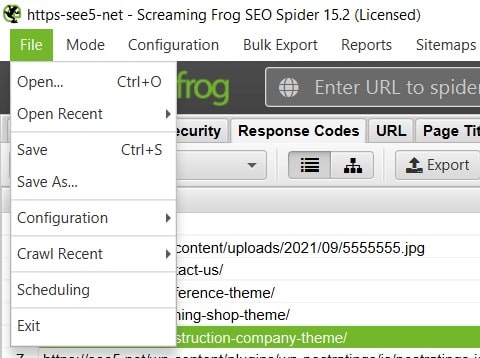

ذخیره سازی اطلاعات

بهتره تمامی دادههای خودتون رو با توجه به داشتن لایسنس درون برنامهای ذخیره کنید. ذخیره کردن اطلاعات به دو روش زیر صورت میگیره.

1- از طریق مراجعه به قسمت File و انتخاب گزینه Open (Ctrl+O)

2- از طریق مراجعه به قسمت File و انتخاب گزینه Save (Ctrl+O)